推 kiss78832 : 能跟我說一下何時台灣才跟得上? 02/12 12:04

推 pmes9866 : DEEPSEEK,MINIMAX也推新的 02/12 12:04

推 jenchieh5 : 有沒有新的鬼故事模板... 02/12 12:04

→ Feting : 去年殺nv,今年殺狗 02/12 12:04

→ bnn : 99 GOOG 02/12 12:04

→ pmes9866 : 台灣有台積電 02/12 12:04

→ lusiao1978 : 唉都什麼時候了還在刷比分 02/12 12:04

噓 kinve1014 : 上次那個還有氣嗎 放消息就是出貨吧 02/12 12:05

推 yellone741 : 怎麼有種既是感XD 02/12 12:05

推 sixkeeper : 去年已經示範過一次了,這次肯定不能錯過.... 02/12 12:05

→ Feting : 狗狗要多殺個20%了 99狗狗 02/12 12:05

→ barry841120 : 這個鬼故事去年講過了 02/12 12:05

推 post91 : 呃..嗯… 02/12 12:06

噓 sing60905 : 中又贏 02/12 12:06

→ NAVY08 : 看起來GPT越來越難回收成本了,好期待永動機跑不動 02/12 12:06

→ post91 : 都要買晶片的 02/12 12:06

→ NAVY08 : 的時候。 02/12 12:06

推 dannpptt : 又要殺硬體嗎 02/12 12:06

噓 JingPingKing: 沒創意 02/12 12:07

→ laytomalll : 沒有新的劇本? 02/12 12:07

噓 iahc5566 : AI目前就都狗屁 02/12 12:07

推 ezorttc : deepfuck 02/12 12:09

推 seemoon2000 : 去年過年的劇本又來一次 02/12 12:09

推 fhjqwefs : 好厲害 大家都懂 02/12 12:10

推 Gipmydanger : 贏麻了 02/12 12:11

噓 liscp : 去年演過一次 02/12 12:12

推 iamjojo : 今天就抓出說自己是claude 笑死 02/12 12:12

推 minazukimaya: 蒸餾真的猛XD 看來以後預訓練都是花錢讓別人爽而已 02/12 12:13

推 HiuAnOP : 笑死 02/12 12:13

推 fjuke : 鬼故事來了 年後開盤有鑽石撿嗎 02/12 12:13

推 starport : 這劇本我看過了 謝謝 02/12 12:13

→ minazukimaya: 蒸餾效果這麼好 以後大家都蒸餾就好啦 02/12 12:13

→ minazukimaya: 接下來競爭力就真的是比推論成本了 02/12 12:14

推 JKjohnwick : 誰信 02/12 12:14

噓 KRV5566 : 去年過年就演過一遍了 02/12 12:14

推 a77942002 : 說那麼多我還不是需要google~C 02/12 12:15

推 SuiseiTrain : 一定爛 02/12 12:15

推 jackie0414 : 中國什麼都贏 贏麻了 02/12 12:15

推 dannpptt : 比誰家模型訓練成本最低! 捲起來~ 02/12 12:15

推 toff887 : 好耶 又能加碼賺更多 02/12 12:16

推 lawy : 贏麻啦哪次不贏 02/12 12:19

推 longmok2500 : 又來? 02/12 12:19

推 fcuhua : 去年被deepshit 騙過一次了 今年還來? 02/12 12:19

推 antiPUMA : 這劇本好熟悉 02/12 12:20

→ lackofblack : 喔喔喔喔是喔好怕喔 02/12 12:20

推 chita0258 : 又一個貼牌大模型 好喔 02/12 12:21

推 tchialen : 新年鬼故事 台股又又又躲崩 02/12 12:22

推 yuinghoooo : 中國什麼都要幹到供給過剩,房地產暴雷、電動車也 02/12 12:23

→ yuinghoooo : 炸掉、現在AI也要免費送 02/12 12:23

→ jack1042 : 只針對單一訓練資料拿高分 實際上好不好用不知道 02/12 12:23

→ yuinghoooo : 反正白菜價也不錯,不拿白不拿 02/12 12:24

推 TheRock5566 : 沒用呀 美國又不用你們的 02/12 12:24

→ lishiter : 中又贏,無敵的吧 02/12 12:25

推 KKKAO : 支又贏 支吹高潮 02/12 12:25

推 JaccWu : 中國最喜歡的 燒錢搶市占環節 02/12 12:25

→ JaccWu : 提高大家變現難度 02/12 12:25

推 brian040818 : 長江存儲不炒了嗎 02/12 12:26

→ JaccWu : 然後技術是抄/蒸餾來的 壓低成本 02/12 12:27

→ asjh612 : 那個deepseek我們不要了 02/12 12:27

→ materu : 最爛是阿祖。砸大錢被蒸餾仔超車兩次 02/12 12:28

推 syk1104 : 哇,好厲害喔,中又贏(平淡 02/12 12:28

→ asirk124 : 就互相競爭,有什麼了不起的,這之後也會被超越的 02/12 12:29

→ poeoe : 現在AI就看中美爭霸而已 其他人都邊緣化了 02/12 12:30

推 maniaque : 現在大陸基建能源多到滿出來,就只差算力而已 02/12 12:31

推 ltflame : 谷歌只要等別家慢慢追上再不慌不忙丟出新的碾壓模 02/12 12:31

→ ltflame : 型就好 02/12 12:31

→ maniaque : 別的國家因為電力散熱基建跟不上,蒜粒放倉庫 02/12 12:32

推 lesbian5566T: 凹嗚~狗狗買在321,慘了我要哭了 02/12 12:32

推 as6633208 : 孤狗被殺到頭破血流 好扯 02/12 12:32

推 ccr0857 : 要過年了 又來? 02/12 12:32

噓 Westzone : 科科,整天吹,上次吹完deepseek後一樣沒人鳥 02/12 12:33

推 sirins : 別吹了 大家都走路去洗澡 02/12 12:35

→ sirins : *洗車 02/12 12:35

推 g5637128 : 贏麻了 02/12 12:37

→ WenliYang : 好了啦 我信還不行嗎 02/12 12:37

推 s213092921 : 華為昇騰算卡發威了XDD 02/12 12:37

推 yuebin : 讚啦!過完年有便宜的GOOG可以撿 02/12 12:38

推 heavenlyken : 又掰故事壓低吃貨 玩不膩 02/12 12:38

推 takeda3234 : 中國ai洗不動了 02/12 12:39

推 maxman77 : 好了啦 天朝又雙贏了 贏到沒朋友 02/12 12:40

推 Marginal : 來了,蒜粒過剩…「那個GPU我們不要了」 02/12 12:41

推 lbjstar : 好了啦,中國一定強 02/12 12:42

→ lbjstar : 意思意思 跌個5% 讓我補票上車 02/12 12:43

推 avmm9898 : 支贏 可惜支吹都很窮買不起陸股 02/12 12:44

→ keltt : 強不強需要時間證明,但中吹又能開始洗文大吹特吹了 02/12 12:44

推 twchih018 : 支那AI還真不敢用 02/12 12:45

推 andy79323 : 4.7 flash還行 02/12 12:46

推 yulun1984 : 大家都會 02/12 12:47

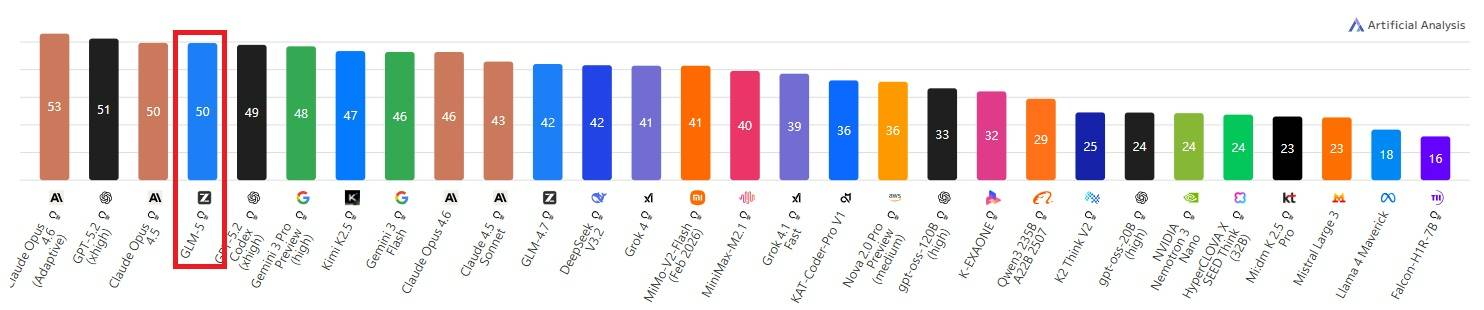

→ pinkg023 : 改拿打敗gemini打廣告了,gpt真的下去了嗎 02/12 12:48

推 lahugh : 勝啦 那次不勝 02/12 12:49

推 dogalan : 等贏過claude opus 4.6再跟我說 02/12 12:51

推 guanting886 : 智譜炒股有一套,股東賺利益 用戶享免費 02/12 12:52

→ guanting886 : GLM-5 就是一套蒸餾Claude的鬼才炒股之作 02/12 12:53

→ ma721 : 鬼故事太早了 02/12 12:54

→ FatFatQQ : 美國軟體股被血洗 有夠慘 02/12 12:54

→ guanting886 : 但對用戶來說應該性價比拉滿 02/12 12:54

推 chachabo : 99goog 02/12 12:55

推 s213092921 : 去年DS時刻讓歐美破防,今年字節SD時刻讓歐美AI破防 02/12 12:56

推 roseritter : 遲早會開發反蒸餾的惡搞方法 02/12 12:56

→ qazws931 : 所以上次那個deepsh_t怎麼了 02/12 12:57

推 ga023630 : 破三小防 支那人開口就說謊 02/12 12:58

→ ga023630 : 蒸餾claude的垃圾模型 笑死 02/12 12:58

→ ga023630 : 沒有美國人創新 支那什麼東西都做不出 02/12 12:58

推 s881720 : 過年鬼故事 又要來一次喔 好了啦 02/12 12:59

噓 toper : 蒸餾蒸起來 02/12 13:00

→ qazws931 : 用過一次還被看穿的招 再用是能騙到什麼人 02/12 13:00

→ FatFatQQ : 美國被打到滿地找牙 也太慘 美吹繼續裝瞎哈哈 02/12 13:00

推 ga023630 : 支吹真可憐 偷東西還輸人 02/12 13:01

→ ga023630 : HBM EUV 也都做不出 偷東西還輸 可憐啊 02/12 13:01

噓 cityhunter04: 忘記去年那個dp 了嗎?還要繼續吹捧啊? 02/12 13:03

推 yayohola : 感覺openai才要怕 02/12 13:05

→ lll111111111: 等等八卦一堆支吹網軍又跑來.. 02/12 13:06

推 nikoyaka9527: gemini有全家桶設計太方便了 02/12 13:06

推 ga023630 : 最近還抓到支那間諜偷TPU 的新聞 可憐啊 廢物國家 02/12 13:07

→ s213092921 : HBM今年要國產囉,EUV原型機已經出來了 02/12 13:07

推 a210510 : 去年鬼故事要開始了嗎 02/12 13:07

→ a210510 : AI需求衰退 記憶體需求也衰退 02/12 13:08

→ qazws931 : 連拆解DUV都還裝不回去 現在幻想EUV做出來了喔 02/12 13:08

→ ga023630 : 笑死 陸製HBM那種垃圾東西沒人要 EUV原型機還在吹 02/12 13:09

→ ga023630 : 長新存儲連1a都做不出 可憐 02/12 13:09

推 swbthj : 這是今年的鬼故事嗎? 02/12 13:10

推 flash789 : 最多死openai,狗的優勢沒變 02/12 13:10

→ hihi29 : 東升西降 以後ai就是大陸說的算的產業 02/12 13:12

→ FatFatQQ : 美國AI全是華人 有人超崩潰 02/12 13:14

推 ga023630 : 支那人只剩這個可以說嘴嗎 可憐 廢到笑 02/12 13:15

→ augustlion : 好了啦 去年deepseek用過了 02/12 13:22

推 house911 : 去年過年封關期間的鬼故事 又想來一次 ? 02/12 13:26

推 lyxiang : 這個劇情去年好像看過了欸 02/12 13:28

→ vltw5v : 跟去年的鬼故事差不多 有沒有新一點的? 02/12 13:29

推 dbdudsorj : 一年一度的大特價要來了 這次記得歐硬 02/12 13:29

推 deepelves : 剛封關馬上就鬼故事 02/12 13:31

推 wolver : 台灣沒電 02/12 13:32

噓 as10082 : 哇靠有智障在吹中國ai真可憐 你不知道中國人也不用 02/12 13:38

→ as10082 : 自己ai嗎 02/12 13:38

→ as10082 : 黃種人都是華人美國崩潰 02/12 13:38

推 Merman19 : deepseek演過一次了 02/12 13:39

推 pansquarl : 這麼厲害,所以可以低腰撿 Google 了嗎 02/12 13:39

→ auther : 為什麼總是別人先推出中國再推出,能不能 有創意一點 02/12 13:39

推 al0w0l : 進一步縮小了與前沿模型之間的差距…怎到了標題就 02/12 13:39

→ al0w0l : 變成勝過Xxx 02/12 13:39

→ tom77588 : 放屁 02/12 13:40

→ gk1329 : 太猛了 還開源誒 02/12 13:40

噓 Pixma258 : 蒸嵧酒就便宜貨沒人要喝呀,AI也是一樣 02/12 13:40

推 MumiPyonPyon: 現在最紅的是seedance 2.0, 這個根本無人在意 02/12 13:41

→ qazws931 : 看被deepshit騙過一次的會不會再被騙一次 02/12 13:42

![[新聞] 台股休市!韓股盤中勁揚2.6%改寫新高 - 股票 - PTT.BEST 批踢踢爆文](https://i.mopix.cc/LKZ8Nd.jpg)

![[請益] 台積電年後開盤直接2000元的可能性高嗎? - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/AsjKYh1.jpeg)

![[請益] 台積電年後開盤直接2000元的可能性高嗎? - 股票 - PTT.BEST 批踢踢爆文 2](https://i.imgur.com/9KME2bb.jpeg)

![[請益] 台積電年後開盤直接2000元的可能性高嗎? - 股票 - PTT.BEST 批踢踢爆文 3](https://i.mopix.cc/sgUf5w.jpg)

![[新聞] 差距正在擴大!結構失衡 學者:股市加劇 - 股票 - PTT.BEST 批踢踢爆文](https://i.mopix.cc/S42SWP.jpg)

![[新聞] 差距正在擴大!結構失衡 學者:股市加劇 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.mopix.cc/QLfynU.jpg)

![[新聞] 差距正在擴大!結構失衡 學者:股市加劇 - 股票 - PTT.BEST 批踢踢爆文 3](https://i.mopix.cc/PBw4tW.jpg)

![[新聞] 川普曝「我不喜歡她說話口氣」 所以對 - 股票 - PTT.BEST 批踢踢爆文](https://cdn2.ettoday.net/images/8335/d8335033.jpg)

![[新聞] 川普曝「我不喜歡她說話口氣」 所以對 - 股票 - PTT.BEST 批踢踢爆文 2](https://cdn2.ettoday.net/images/8159/d8159755.jpg)

![[請益] 有人抱台指期過年嗎? - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/0rpNce5.jpeg)

![[請益] 有人抱台指期過年嗎? - 股票 - PTT.BEST 批踢踢爆文 2](https://i.mopix.cc/TOp5SB.jpg)

![[閒聊] 2026/02/12 盤後閒聊 - 股票 - PTT.BEST 批踢踢爆文](https://pbs.twimg.com/media/HA3n85ma8AETz1U.jpg)

![[閒聊] 2026/02/12 盤後閒聊 - 股票 - PTT.BEST 批踢踢爆文 2](https://images2.imgbox.com/65/c6/DrEdd6nH_o.jpg)

![[閒聊] 2026/02/12 盤後閒聊 - 股票 - PTT.BEST 批踢踢爆文 3](https://i.imgur.com/XnlHXFi.jpeg)

![[請益] 股票健檢 - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/II6YtOn.jpeg)

![[請益] 股票健檢 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.mopix.cc/xBPvJ7.jpg)

![[請益] 股票健檢 - 股票 - PTT.BEST 批踢踢爆文 3](https://i.imgur.com/CZkRQWi.jpeg)

![[請益] 信貸投入大盤-借新還舊請益 - 股票 - PTT.BEST 批踢踢爆文](http://i.imgur.com/7lnLojX.jpg)

![[心得] 美國各項貸款違約率 - 股票 - PTT.BEST 批踢踢爆文](https://i.mopix.cc/xPYDBX.jpg)

![[心得] 美國各項貸款違約率 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.imgur.com/k962U0m.jpeg)

![Re: [新聞] 卓榮泰:全面接受全世界先進的新式核能技術 - 股票 - PTT.BEST 批踢踢爆文](https://i.meee.com.tw/G818P3Y.png)

![Re: [新聞] 卓榮泰:全面接受全世界先進的新式核能技術 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.meee.com.tw/iIVUO3H.png)

![Re: [新聞] 卓榮泰:全面接受全世界先進的新式核能技術 - 股票 - PTT.BEST 批踢踢爆文 3](https://i.meee.com.tw/yvNVTHT.png)

![[情報] 115年02月11日信用交易統計 - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/tCQZWGd.jpg)

![[情報] 美國非農就業數據 - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/Hks9pWO.jpeg)

![[情報] 美國非農就業數據 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.imgur.com/phZndV5.jpeg)

![[情報] 美國非農就業數據 - 股票 - PTT.BEST 批踢踢爆文 3](https://i.imgur.com/GR3yPRZ.jpeg)

![[新聞] 謝金河:馬年迎來兩大順風車 台股今年喜氣 - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/dIDDSPA.jpeg)

![[新聞] 謝金河:馬年迎來兩大順風車 台股今年喜氣 - 股票 - PTT.BEST 批踢踢爆文 2](https://i.imgur.com/kvEd1iS.jpeg)

![[新聞] 台股挑戰四萬點?證交所董事長林修銘:未 - 股票 - PTT.BEST 批踢踢爆文](https://i.imgur.com/7UhHvNL.jpeg)

![[情報] 2545 皇翔 賣台積電165張 約賺2549萬 - 股票 - PTT.BEST 批踢踢爆文](https://imgpoi.com/i/44VXRV.jpg)